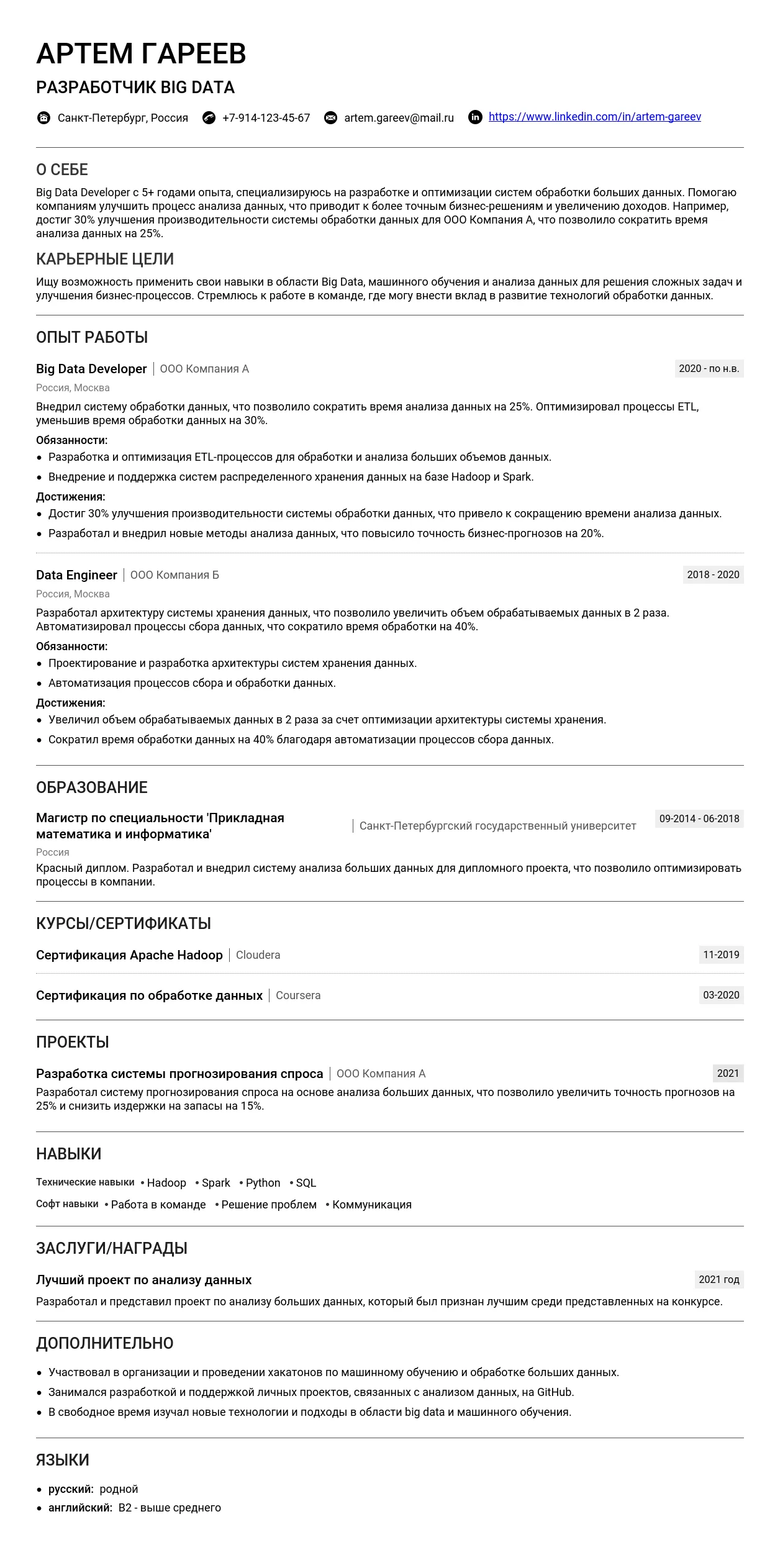

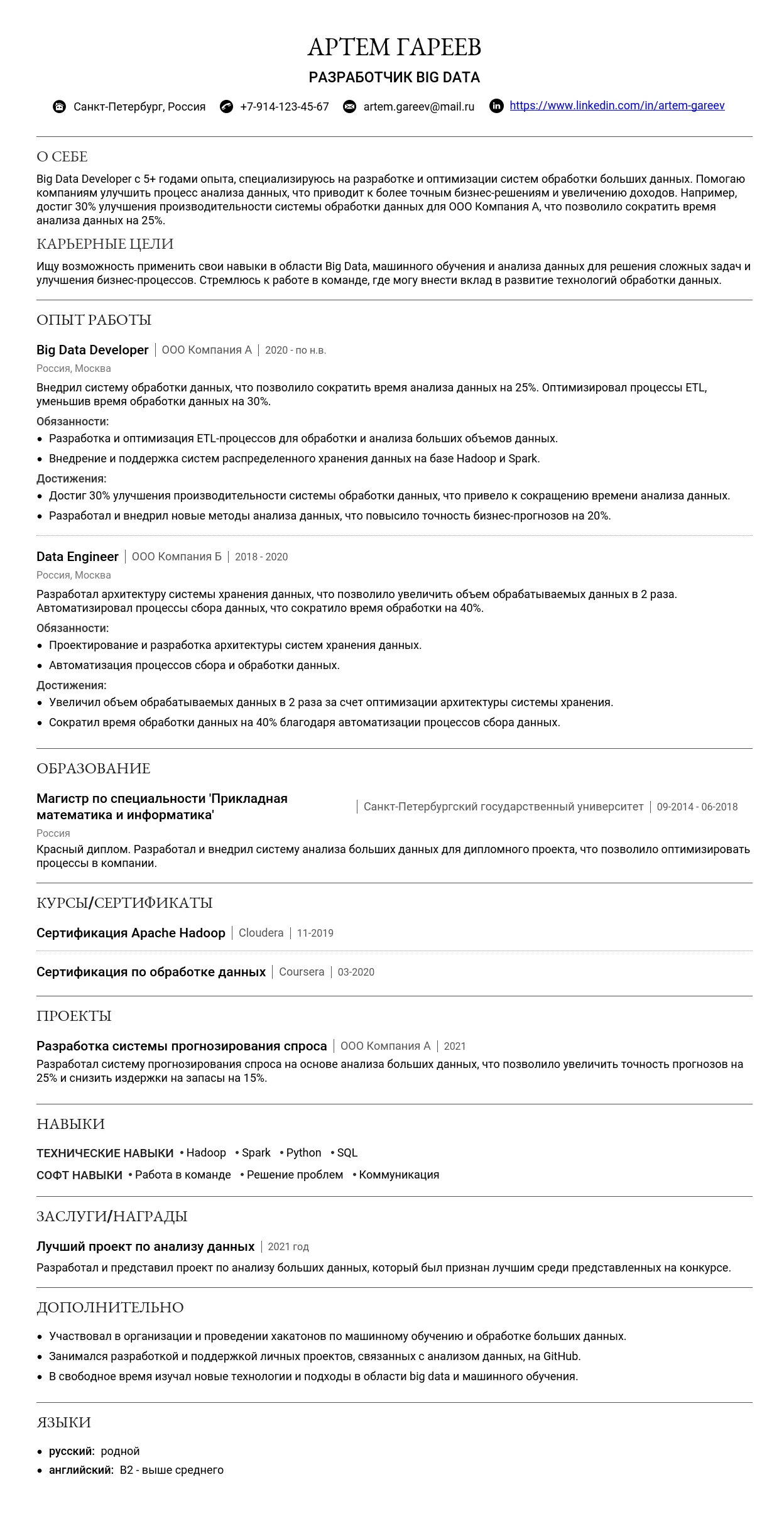

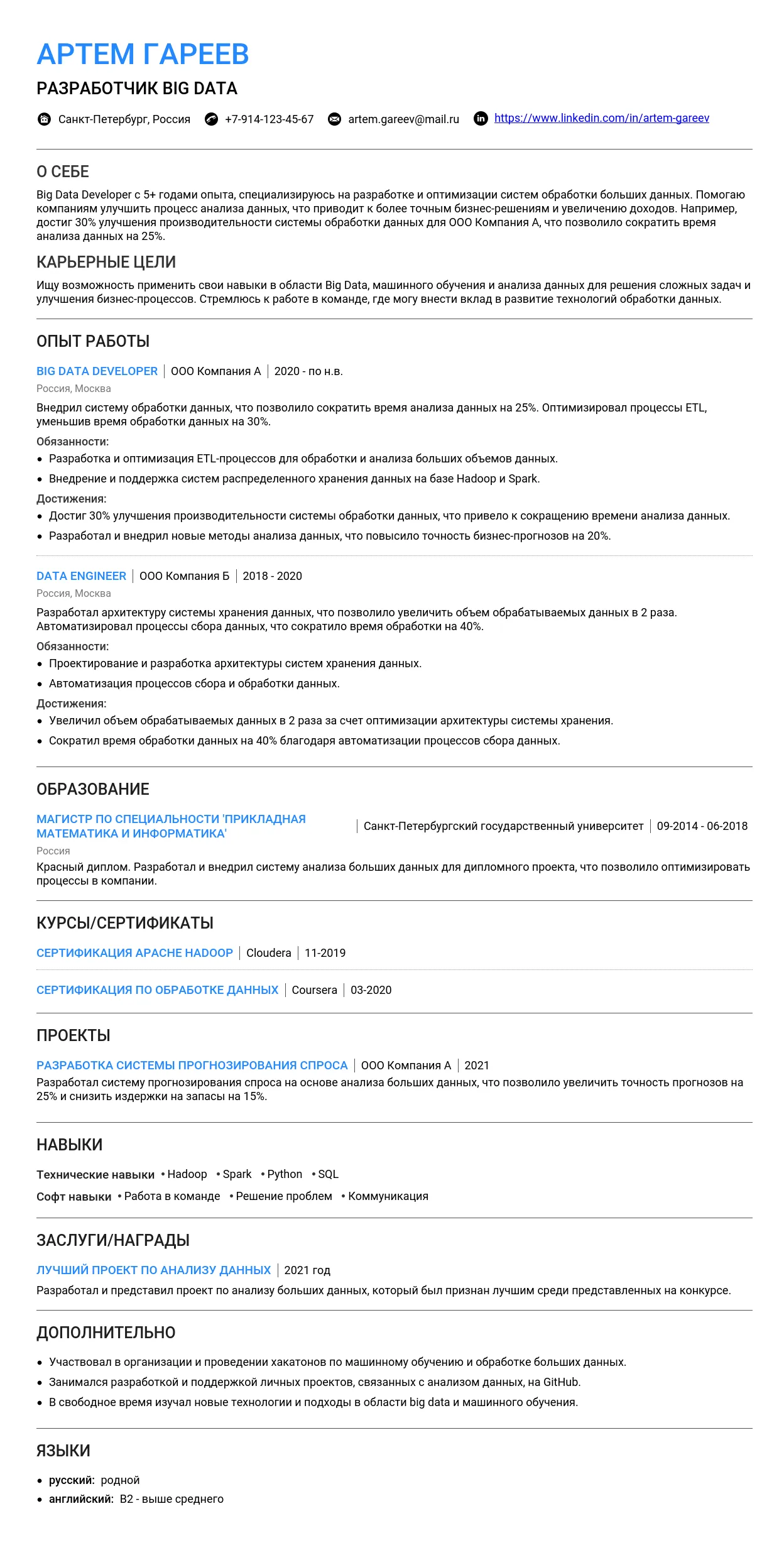

Хотите составить сильное резюме, которое выделит вас среди других кандидатов? Изучите наш пример резюме big data developerа и узнайте, как презентовать свой опыт и навыки, чтобы получить работу мечты.

На этой странице мы предлагаем не просто посмотреть на готовое резюме, но и разобраться, как шаг за шагом создать свое собственное, соответствующее актуальным требованиям работодателей. Наш подробный гид охватывает все ключевые разделы:

- Как правильно оформить заголовок и контактные данные;

- Что написать в разделе "О себе", чтобы сразу заинтересовать рекрутера;

- Как структурировать опыт работы и подчеркнуть достижения;

- Важность образования, курсов и сертификатов;

- Какие Hard и Soft Skills важны для big data developerа.

Мы дадим советы как начинающим специалистам, так и опытным профессионалам, объясним, как адаптировать резюме под конкретные вакансии и избежать распространенных ошибок. Изучив пример, вы сможете создать резюме с помощью нашего конструктора резюме. 👍

📝 Выберите подходящий пример и заполните в конструкторе

Пример резюме - разбираем по частям

Как правильно назвать должность

Заголовок резюме — это первое, что увидит работодатель, поэтому он должен быть четким, понятным и соответствовать вашей специализации. Для профессии "Big Data Developer" важно указать уровень вашей экспертизы (junior, middle, senior) и ключевые технологии, с которыми вы работаете.

- Big Data Developer

- Senior Big Data Engineer

- Data Processing Specialist

- Big Data Solutions Architect

- Junior Hadoop Developer

- Machine Learning and Big Data Specialist

- Cloud Big Data Engineer

- Data Guy (слишком неформально и размыто)

- Master of Data (непрофессионально и неинформативно)

- Data Scientist and Big Data Developer (слишком длинно и смешивает роли)

- Big Data Guru (неуважительно и не соответствует профессиональному стилю)

Ключевые слова для заголовка

Используйте ключевые слова, которые помогут вашему резюме выделиться и соответствовать требованиям работодателя:

- Big Data

- Data Engineering

- Hadoop

- Spark

- ETL

- Cloud (AWS, Azure, GCP)

- Data Pipeline

Контактная информация

Контактная информация должна быть полной, актуальной и профессионально оформленной. Убедитесь, что работодатель сможет легко связаться с вами.

Полный список необходимых контактов

- Имя и фамилия: Иван Иванов

- Телефон: +7 (999) 123-45-67

- Email: ivan.ivanov@example.com

- Город проживания: Москва, Россия

- LinkedIn: linkedin.com/in/ivan-ivanov

- GitHub: github.com/ivanov

Оформление ссылок на профессиональные профили

Ссылки на профессиональные профили должны быть краткими и легко читаемыми. Используйте короткие URL или гиперссылки с понятным текстом.

LinkedIn: linkedin.com/in/ivan-ivanov

LinkedIn: linkedin.com/in/ivan-ivanov-1234567890abcdef

Требования к фото

Фото не является обязательным для профессии "Big Data Developer", но если вы решите его добавить, убедитесь, что оно профессиональное и соответствует деловому стилю.

Хорошее фото: Четкое изображение в деловой одежде на нейтральном фоне.

Плохое фото: Размытое изображение с неряшливым фоном или в неформальной одежде.

Распространенные ошибки в оформлении контактов

- Некорректный email: Использование неформальных адресов, таких как "superhacker@example.com".

- Отсутствие ключевых контактов: Не указаны LinkedIn или GitHub.

- Длинные URL: Ссылки, которые трудно скопировать или запомнить.

Профессиональное онлайн-присутствие

Для Big Data Developer важно показать свои навыки и проекты через профессиональные платформы.

Для профессий с портфолио

- GitHub: Укажите ссылку на ваш профиль с примерами кода и проектов.

- LinkedIn: Подробно опишите ваш опыт и навыки. Как создать профиль на LinkedIn.

- Собственный сайт или блог: Если у вас есть, добавьте ссылку.

Как оформить ссылки на портфолио

GitHub: github.com/ivanov

GitHub: github.com/ivanov/super-secret-repo

Для профессий без портфолио

- LinkedIn: Укажите ваш профиль с описанием опыта и навыков. Как создать профиль на LinkedIn.

- hh.ru: Добавьте ссылку на ваше резюме. Как создать резюме на hh.ru.

- Сертификаты: Укажите ссылки на подтвержденные сертификаты (например, Coursera, AWS, Google Cloud).

Распространенные ошибки и как их избежать

- Неполная контактная информация: Убедитесь, что указаны все ключевые контакты.

- Непрофессиональные ссылки: Используйте короткие и понятные URL.

- Отсутствие онлайн-присутствия: Добавьте ссылки на GitHub, LinkedIn или hh.ru.

Как правильно написать раздел "О себе" в резюме Big Data Developer

Оптимальный объем: 5-7 предложений (50-100 слов).

Обязательная информация:

- Краткое описание профессионального опыта или образования (если опыта нет).

- Ключевые навыки, связанные с Big Data (например, Hadoop, Spark, SQL, Python).

- Цель поиска работы (например, "развитие в области обработки больших данных").

Стиль и тон: Профессиональный, но не слишком формальный. Упор на конкретику и достижения.

Что не стоит писать:

- Лишние детали о личной жизни (например, "люблю готовить").

- Общие фразы без подтверждения (например, "ответственный и целеустремленный").

- Негатив о предыдущих работодателях.

5 характерных ошибок:

- "Ищу работу с высокой зарплатой" (не указывайте финансовые ожидания в этом разделе).

- "Ответственный и коммуникабельный" (без подтверждения это неинформативно).

- "Работал с Big Data" (не конкретно, лучше указать технологии).

- "Нет опыта, но хочу научиться" (лучше сделать акцент на образовании и мотивации).

- "Люблю решать сложные задачи" (без примеров это звучит шаблонно).

Примеры для начинающих специалистов

Для начинающих важно сделать акцент на образовании, мотивации и базовых навыках. Укажите проекты (даже учебные), которые демонстрируют вашу способность работать с данными.

Молодой специалист в области Big Data, выпускник магистратуры по прикладной математике. Владею основами Python, SQL и Hadoop. Участвовал в учебных проектах по обработке больших данных, включая анализ датасетов с использованием Apache Spark. Ищу возможность развиваться в области data engineering и внедрять решения для анализа данных.

Сильные стороны: Упор на образование и учебные проекты, демонстрация базовых навыков.

Недавно завершил курс по Big Data, где освоил работу с Apache Kafka, Hadoop и Spark. В рамках курса разработал проект по анализу потоковых данных для прогнозирования спроса. Хочу продолжить развиваться в области обработки и анализа больших данных, применяя полученные навыки на практике.

Сильные стороны: Упоминание конкретных технологий и учебного проекта.

Имею базовые знания в области Big Data и опыт работы с Python и SQL. В 2025 году участвовал в хакатоне, где разработал решение для кластеризации данных с использованием K-means. Стремлюсь к профессиональному росту в области data science и machine learning.

Сильные стороны: Упоминание хакатона и конкретного алгоритма, демонстрация интереса к смежным областям.

Примеры для специалистов с опытом

Для опытных специалистов важно показать достижения, профессиональный рост и специализацию. Укажите конкретные проекты, технологии и результаты.

Big Data Developer с 4-летним опытом работы. Специализируюсь на разработке и оптимизации ETL-процессов с использованием Apache Spark и Hadoop. Участвовал в проектах по обработке данных для e-commerce, что позволило увеличить скорость анализа данных на 30%. Ищу возможность работать с масштабными проектами в области data engineering.

Сильные стороны: Упоминание конкретных технологий, проектов и результатов.

Опыт работы с Big Data более 5 лет. Разрабатывал системы для обработки потоковых данных с использованием Apache Kafka и Flink. Руководил командой из 3 разработчиков, что позволило сократить время реализации проекта на 20%. Ищу вызовы в области real-time data processing.

Сильные стороны: Упоминание управленческого опыта и конкретных результатов.

Специалист в области Big Data с опытом работы в финансовом секторе. Разрабатывал системы для прогнозирования рыночных трендов с использованием машинного обучения и Apache Spark. Увеличил точность прогнозов на 15%. Ищу возможность работать с инновационными проектами в области data science.

Сильные стороны: Упоминание специализации и конкретных результатов.

Примеры для ведущих специалистов

Для ведущих специалистов важно подчеркнуть экспертизу, управленческий опыт и масштаб реализованных проектов. Укажите, как ваша работа повлияла на бизнес.

Ведущий Big Data Developer с 10-летним опытом. Руководил командой из 10 разработчиков в проекте по созданию системы обработки данных для ритейла, что позволило сократить затраты на инфраструктуру на 25%. Специализируюсь на оптимизации распределенных систем и внедрении machine learning в процессы анализа данных.

Сильные стороны: Упоминание масштаба проекта, управленческого опыта и результатов.

Эксперт в области Big Data с опытом работы в крупных технологических компаниях. Руководил разработкой платформы для анализа данных объемом более 1 петабайта. Внедрил решения на основе Apache Kafka и Flink, что увеличило производительность системы на 40%. Ищу возможность работать с глобальными проектами.

Сильные стороны: Упоминание масштаба данных и конкретных технологий.

Big Data Architect с 12-летним опытом. Разрабатывал и внедрял решения для обработки данных в банковской сфере, что позволило сократить время обработки транзакций на 50%. Руководил командой из 15 разработчиков и активно участвовал в создании архитектуры данных.

Сильные стороны: Упоминание бизнес-результатов и управленческого опыта.

Практические советы по написанию

Ключевые фразы для профессии Big Data Developer:

- Apache Spark

- Hadoop

- ETL-процессы

- Data engineering

- Real-time data processing

- Machine learning

- Data pipelines

- Scalability

- Data warehousing

- Big Data архитектура

10 пунктов для самопроверки текста:

- Конкретность: Указаны ли конкретные технологии и проекты?

- Результаты: Есть ли упоминание о достижениях и их влиянии на бизнес?

- Профессиональный тон: Текст написан без излишней эмоциональности?

- Объем: Текст укладывается в 5-7 предложений?

- Актуальность: Указаны ли современные технологии (например, Spark, Kafka)?

- Целеустремленность: Указана ли цель поиска работы?

- Отсутствие шаблонов: Нет ли общих фраз вроде "ответственный и коммуникабельный"?

- Специализация: Указана ли ваша узкая специализация (например, data engineering)?

- Ошибки: Проверен ли текст на грамматические и стилистические ошибки?

- Адаптация: Текст адаптирован под конкретную вакансию?

Как адаптировать текст под разные вакансии:

- Изучите требования вакансии и включите ключевые слова из описания.

- Сделайте акцент на тех навыках и опыте, которые наиболее релевантны для конкретной роли.

- Укажите, как ваш опыт может быть полезен для компании (например, "имею опыт в retail, что может быть полезно для вашего проекта").

Как структурировать описание опыта работы

Формат заголовка: Название должности, компания, даты работы (например, "Big Data Developer, ООО "ТехноЛаб", 03.2025–настоящее время").

Оптимальное количество пунктов: 4–6 ключевых обязанностей или достижений для каждой позиции.

Совмещение должностей: Указывайте через слэш (например, "Big Data Developer / Data Engineer").

Даты работы: Указывайте в формате "месяц.год" (например, "03.2025–10.2025"). Если работаете по настоящее время, пишите "настоящее время".

Описание компании: Коротко опишите компанию, если она малоизвестна. Укажите ссылку на сайт, если это уместно (например, "Компания, специализирующаяся на анализе больших данных для ритейла").

Как правильно описывать обязанности

Сильные глаголы действия:

- Разрабатывать

- Оптимизировать

- Реализовывать

- Анализировать

- Интегрировать

- Автоматизировать

- Моделировать

- Тестировать

- Внедрять

- Координировать

- Улучшать

- Обучать

- Исследовать

- Обеспечивать

- Масштабировать

Как избежать перечисления обязанностей: Добавляйте контекст и результаты. Например, вместо "Разрабатывал ETL-процессы" напишите "Разработал и внедрил ETL-процессы, что сократило время обработки данных на 30%".

Примеры превращения обязанностей в достижения:

Типичные ошибки:

Подробнее о написании раздела "Опыт работы" читайте здесь.

Как описывать достижения

Квантификация результатов: Используйте цифры и проценты. Например, "Увеличил производительность системы на 40%".

Метрики для Big Data Developer:

- Объем обрабатываемых данных (например, "1 ТБ/день").

- Скорость обработки (например, "сократил время обработки на 30%").

- Точность моделей (например, "улучшил точность прогнозов на 15%").

Если нет четких цифр: Опишите качественные улучшения, например, "Внедрил новые методы анализа, что повысило точность прогнозов".

Примеры формулировок:

Как указывать технологии и инструменты

Где указывать: В отдельном разделе "Технический стек" или в описании каждой позиции.

Группировка: По категориям (например, "Языки программирования: Python, Scala", "Базы данных: Hadoop, Cassandra").

Уровень владения: Указывайте, если это важно (например, "Python: продвинутый уровень").

Актуальные технологии: Hadoop, Spark, Kafka, Python, Scala, SQL, NoSQL, TensorFlow, Kubernetes.

Примеры описания опыта работы

Для начинающих:

Для специалистов с опытом:

Для руководящих позиций:

Как структурировать раздел "Образование"

Раздел "Образование" лучше располагать в начале резюме, если вы недавний выпускник или у вас мало опыта работы. Для опытных специалистов его можно разместить после раздела "Опыт работы".

Если вы писали дипломную работу или участвовали в проектах, связанных с Big Data, обязательно укажите это. Например:

Оценки стоит указывать только если они высокие (например, "красный диплом" или GPA выше 4.5).

Дополнительные курсы в вузе можно описать так:

Подробнее о структуре раздела можно узнать здесь.

Какое образование ценится в Big Data Developer

Наиболее ценными специальностями являются:

- Прикладная математика и информатика

- Компьютерные науки

- Data Science

- Программная инженерия

Если ваше образование не связано с Big Data, покажите его связь с профессией. Например:

Примеры описания образования:

Курсы и дополнительное образование

Для Big Data Developer важно указать курсы по следующим темам:

- Обработка больших данных (Hadoop, Spark)

- Машинное обучение

- Базы данных (SQL, NoSQL)

- Программирование на Python, Scala

Онлайн-образование можно описать так:

Топ-5 актуальных курсов:

- "Big Data with Spark and Hadoop" (Coursera)

- "Data Engineering, Big Data, and Machine Learning on GCP" (Coursera)

- "Data Science and Machine Learning Bootcamp" (Udemy)

Сертификаты и аккредитации

Важные сертификаты для Big Data Developer:

- Cloudera Certified Data Engineer

- Google Cloud Professional Data Engineer

- AWS Certified Big Data – Specialty

Сертификаты указывайте с датой получения и сроком действия, если он ограничен.

Пример:

Примеры оформления раздела

Для студентов и выпускников:

Магистр компьютерных наук, МГУ (2025). Дипломный проект: "Оптимизация алгоритмов обработки больших данных".

Стажировка: Яндекс, отдел Big Data (2025, 3 месяца).

Для специалистов с опытом:

Магистр прикладной математики, МФТИ (2020).

Дополнительные курсы: "Big Data with Spark and Hadoop" (Coursera, 2025).

Сертификаты: Cloudera Certified Data Engineer (2025, действует до 2027).

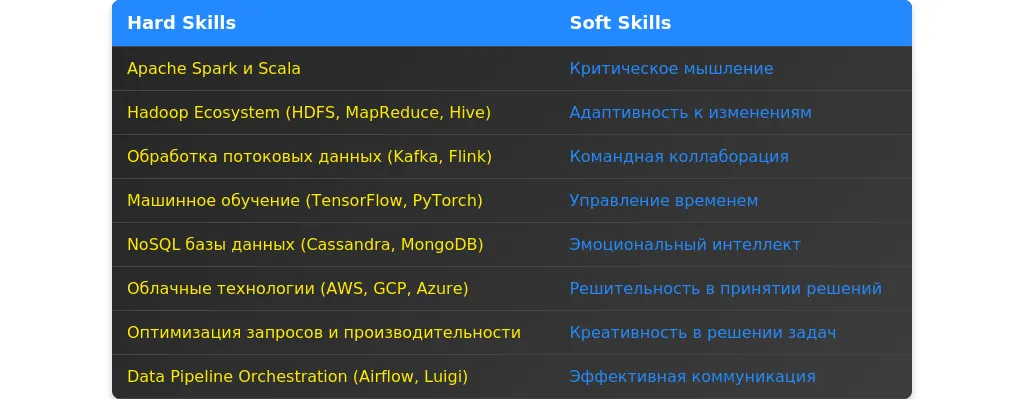

Самые востребованные навыки в 2025 году

В 2025 году работодатели ожидают от Big Data Developer не только базовых знаний, но и специализированных навыков. Вот топ-5 hard skills, которые стоит выделить в резюме:

- Реализация Data Pipelines с использованием Apache Airflow — умение создавать и поддерживать сложные ETL-процессы.

- Работа с распределенными системами (Hadoop, Spark) — опыт обработки данных в кластерных средах.

- MLOps: внедрение и мониторинг моделей машинного обучения — навык, который позволяет переводить ML-модели в продакшн.

- Использование NoSQL баз данных (Cassandra, MongoDB) — опыт работы с нереляционными хранилищами данных.

- Оптимизация запросов в BigQuery — умение работать с большими объемами данных в облачных хранилищах.

Как структурировать раздел навыков

Раздел "Навыки" — это ключевая часть резюме для Big Data Developer. Он должен быть четко структурирован и легко читаем.

Где расположить раздел

Раздел "Навыки" лучше разместить после блока "О себе" или "Цель", но до описания опыта работы. Это позволит сразу привлечь внимание рекрутера.

Как группировать навыки

Навыки следует разделить на категории и подкатегории. Например:

- Технические навыки: языки программирования, базы данных, инструменты анализа данных.

- Личные качества: коммуникация, работа в команде, управление временем.

- Дополнительные навыки: знание методологий разработки, опыт работы с облачными платформами.

3 варианта структуры с примерами

Вариант 1: Категории и подкатегории

- Технические навыки

- Python, Java, Scala

- Hadoop, Spark, Kafka

- Личные качества

- Коммуникабельность

- Организованность

Вариант 2: Список с уровнями владения

- Python (продвинутый)

- Spark (продвинутый)

- Kafka (средний)

Вариант 3: Краткий список ключевых навыков

- Big Data: Hadoop, Spark, Kafka

- Языки программирования: Python, Java

- Облачные платформы: AWS, Azure

Подробнее о том, как правильно добавлять навыки в резюме, читайте здесь.

Технические навыки для Big Data Developer

Технические навыки (hard skills) — это основа профессии Big Data Developer. Они должны быть актуальными и соответствовать требованиям рынка.

Обязательные навыки

- Языки программирования: Python, Java, Scala

- Обработка данных: Hadoop, Spark, Kafka

- Базы данных: SQL, NoSQL (MongoDB, Cassandra)

- Облачные платформы: AWS, Google Cloud, Azure

- Инструменты анализа данных: Pandas, NumPy, TensorFlow

Актуальные технологии 2025 года

- Распределенные вычисления: Apache Flink, Dask

- Машинное обучение: PyTorch, XGBoost

- Реальные-time данные: Apache Pulsar, Redis

Как указать уровень владения

Используйте шкалу: базовый, средний, продвинутый. Например:

Python (продвинутый), Spark (средний), Kafka (базовый)

Python (знаю), Spark (использую), Kafka (имею опыт)

Как выделить ключевые компетенции

Укажите навыки, которые наиболее востребованы для вашей целевой позиции. Например:

Эксперт в области распределенных вычислений (Spark, Hadoop).

5 примеров описания технических навыков

Big Data: Hadoop, Spark, Kafka (продвинутый уровень).

Языки программирования: Python, Java, Scala (средний уровень).

Облачные платформы: AWS (EC2, S3), Google Cloud (BigQuery).

Машинное обучение: TensorFlow, PyTorch (базовый уровень).

Базы данных: SQL, NoSQL (MongoDB, Cassandra).

Личные качества важные для Big Data Developer

Soft skills не менее важны, чем технические навыки. Они помогают эффективно работать в команде и решать сложные задачи.

Топ-10 важных soft skills

- Коммуникабельность

- Работа в команде

- Организованность

- Аналитическое мышление

- Управление временем

- Креативность

- Стрессоустойчивость

- Обучаемость

- Лидерство

- Решительность

Как подтвердить наличие soft skills

Используйте примеры из прошлого опыта. Например:

Успешно руководил командой из 5 разработчиков в проекте по созданию системы анализа данных.

Хорошо работаю в команде.

Какие soft skills не стоит указывать

- Слишком общие: "Ответственность", "Доброта".

- Не относящиеся к работе: "Люблю готовить".

5 примеров описания личных качеств

Аналитическое мышление: успешно оптимизировал алгоритмы обработки данных, что сократило время выполнения задач на 30%.

Коммуникабельность: регулярно проводил презентации для команды и заказчиков.

Организованность: управлял несколькими проектами одновременно, соблюдая сроки.

Обучаемость: освоил Apache Spark за 2 месяца для выполнения проекта.

Стрессоустойчивость: работал в условиях сжатых сроков, выполняя задачи в срок.

Особенности для разных уровней специалистов

Для начинающих

Если у вас мало опыта, акцентируйте внимание на навыках, которые компенсируют его отсутствие.

- Как компенсировать недостаток опыта: Укажите учебные проекты, курсы и стажировки.

- На что делать акцент: Основные языки программирования (Python, Java), базовые знания Big Data (Hadoop, Spark).

- Потенциал к обучению: Подчеркните готовность изучать новые технологии.

Участвовал в учебном проекте по анализу больших данных с использованием Hadoop и Spark.

Освоил Python и SQL на курсах, применил знания в учебных проектах.

Готов изучать новые технологии, такие как Apache Flink и Kafka.

Для опытных специалистов

Опытные разработчики должны показать глубину экспертизы и уникальные компетенции.

- Глубина экспертизы: Укажите успешные проекты и их результаты.

- Баланс навыков: Сочетайте широкий спектр технологий с углубленными знаниями в ключевых областях.

- Уникальные компетенции: Выделите навыки, которые редко встречаются у других кандидатов.

Разработал систему обработки данных в режиме реального времени с использованием Apache Kafka, что увеличило производительность на 40%.

Эксперт в области машинного обучения и анализа больших данных с использованием TensorFlow и PyTorch.

Уникальный опыт интеграции облачных платформ (AWS, Azure) с системами Big Data.

Типичные ошибки и как их избежать

Топ-10 ошибок в разделе навыков

- Указание устаревших технологий.

- Слишком общие формулировки.

- Отсутствие уровней владения навыками.

- Перечисление нерелевантных навыков.

- Избыточное количество навыков.

- Неправильное группирование навыков.

- Использование жаргона.

- Отсутствие подтверждения навыков примерами.

- Указание навыков, которые не соответствуют уровню кандидата.

- Копирование навыков из других резюме.

Устаревшие навыки и как их заменить

- Устаревший: MapReduce.

- Актуальный: Apache Spark.

Неправильные формулировки

Знаю Hadoop и Spark.

Работал с Hadoop и Spark для обработки больших данных в реальных проектах.

Как проверить актуальность навыков

Изучите вакансии на рынке труда, посмотрите, какие технологии и инструменты востребованы в 2025 году. Используйте профессиональные сообщества и форумы для обновления знаний.

Анализ требований вакансии для Big Data Developer

При анализе вакансии для Big Data Developer важно выделить ключевые требования, которые работодатель считает обязательными. Обратите внимание на технологии, указанные в описании: например, Hadoop, Spark, Kafka, SQL, Python или Scala. Эти навыки часто являются обязательными. Также выделите требования к опыту работы, например, "опыт работы с распределенными системами не менее 3 лет". Желательные требования могут включать знание облачных платформ (AWS, GCP, Azure) или опыт работы с инструментами визуализации данных, например, Tableau.

Скрытые требования можно выявить через анализ описания компании и задач. Например, если компания активно использует машинное обучение, то знание ML-библиотек (TensorFlow, PyTorch) может быть неявным требованием. Также обратите внимание на soft skills: если в вакансии упоминается работа в команде, то важно подчеркнуть навыки коммуникации и совместной работы.

Пример 1: Вакансия требует опыт работы с Apache Spark. Это обязательное требование. В описании также упоминается "знание облачных платформ", что является желательным.

Пример 2: В вакансии указано: "опыт работы с большими данными не менее 5 лет". Это ключевое требование. Скрытое требование: знание инструментов для обработки потоковых данных, так как компания занимается аналитикой в реальном времени.

Пример 3: Вакансия включает требование "знание Python и SQL". Это обязательное. Скрытое требование: умение работать с NoSQL базами данных, так как компания использует MongoDB.

Пример 4: В вакансии указано: "опыт работы с Hadoop и Kafka". Это обязательное. Скрытое требование: знание инструментов для мониторинга, таких как Grafana или Prometheus, так как компания уделяет внимание стабильности систем.

Пример 5: Вакансия требует "опыт работы с машинным обучением". Это обязательное. Скрытое требование: знание библиотек для обработки естественного языка, так как компания работает с текстовыми данными.

Стратегия адаптации резюме для Big Data Developer

Адаптация резюме начинается с анализа ключевых требований вакансии. Основные разделы, которые требуют корректировки: "О себе", "Опыт работы" и "Навыки". Важно расставить акценты на тех аспектах, которые соответствуют ожиданиям работодателя. Например, если вакансия требует опыт работы с Apache Spark, то этот навык должен быть выделен в разделе "Опыт работы" и "Навыки".

Адаптация резюме должна быть правдивой. Не стоит искажать факты, но можно переформулировать опыт, чтобы он лучше соответствовал требованиям. Например, если вы работали с Hadoop, но не использовали Kafka, можно указать, что вы знакомы с концепциями потоковой обработки данных.

Адаптация может быть на трех уровнях:

- Минимальная: Корректировка ключевых слов в резюме, чтобы они соответствовали описанию вакансии.

- Средняя: Перегруппировка разделов и добавление релевантных проектов.

- Максимальная: Полная переработка резюме с акцентом на ключевые требования вакансии.

Адаптация раздела "О себе"

Раздел "О себе" должен быть кратким и релевантным. Укажите ключевые компетенции, которые соответствуют вакансии. Например, если вакансия требует опыт работы с облачными платформами, напишите: "Опыт работы с AWS и GCP для обработки больших данных".

До: "Опытный разработчик с навыками работы с большими данными."

После: "Опытный Big Data Developer с 5-летним стажем работы с Apache Spark и Hadoop. Знание облачных платформ AWS и GCP."

До: "Разрабатываю системы для обработки данных."

После: "Разрабатываю распределенные системы для обработки больших данных с использованием Apache Kafka и Spark."

До: "Работаю с Python и SQL."

После: "Опыт работы с Python для анализа данных и SQL для работы с реляционными базами данных."

Типичные ошибки: излишняя обобщенность, отсутствие ключевых слов, перечисление нерелевантных навыков.

Адаптация раздела "Опыт работы"

В разделе "Опыт работы" важно выделить проекты и задачи, которые соответствуют требованиям вакансии. Например, если вакансия требует опыт работы с Apache Kafka, опишите проект, где вы использовали эту технологию.

До: "Разрабатывал системы для обработки данных."

После: "Разработал и внедрил систему обработки потоковых данных с использованием Apache Kafka, что позволило сократить время обработки на 30%."

До: "Работал с Hadoop."

После: "Организовал хранение и обработку больших данных на кластере Hadoop, что увеличило производительность системы на 20%."

До: "Использовал Python для анализа данных."

После: "Разработал скрипты на Python для автоматизации обработки и анализа данных, что сократило время выполнения задач на 50%."

Ключевые фразы: "разработал и внедрил", "оптимизировал производительность", "автоматизировал процессы".

Адаптация раздела "Навыки"

В разделе "Навыки" важно перегруппировать компетенции, чтобы они соответствовали требованиям вакансии. Например, если вакансия требует знание SQL и Python, эти навыки должны быть на первом месте.

До: "Python, Java, SQL, Hadoop, Spark."

После: "Apache Spark, Hadoop, Python, SQL, Kafka."

До: "Работа с базами данных."

После: "Опыт работы с реляционными (MySQL, PostgreSQL) и NoSQL (MongoDB) базами данных."

До: "Анализ данных."

После: "Анализ больших данных с использованием Python и библиотек Pandas, NumPy."

Работа с ключевыми словами: используйте термины из вакансии, такие как "Big Data", "Data Engineering", "Data Pipeline".

Практические примеры адаптации

Пример адаптации резюме под вакансию с упором на Apache Spark:

До: "Опыт работы с большими данными."

После: "Опыт работы с Apache Spark для обработки и анализа больших данных, включая оптимизацию производительности кластеров."

Пример адаптации резюме под вакансию с упором на облачные платформы:

До: "Работал с облачными сервисами."

После: "Опыт работы с AWS (EC2, S3, Redshift) для хранения и обработки больших данных."

Пример адаптации резюме под вакансию с упором на машинное обучение:

До: "Знание машинного обучения."

После: "Опыт работы с библиотеками машинного обучения (TensorFlow, Scikit-learn) для построения моделей прогнозирования."

Проверка качества адаптации

Чтобы оценить качество адаптации, проверьте, насколько резюме соответствует ключевым требованиям вакансии. Используйте чек-лист:

- Все ключевые навыки из вакансии указаны в резюме.

- Опыт работы описан с акцентом на релевантные проекты.

- Раздел "О себе" содержит ключевые компетенции.

Типичные ошибки: избыточность информации, отсутствие ключевых слов, нерелевантные навыки.

Создайте новое резюме, если текущее не соответствует большому количеству требований вакансии или если вы претендуете на позицию в другой сфере.

⚡ Создайте резюме за 10 минут

10+ профессиональных шаблонов с правильно оформленными разделами для профессии "big data developer". Скачивание в PDF + экспорт в HH.ru.

Смотреть все шаблоны резюме →Часто задаваемые вопросы

Какие навыки обязательно указывать в резюме для Big Data Developer?

В резюме для Big Data Developer важно указать следующие навыки:

- Программирование: Python, Java, Scala, SQL.

- Фреймворки и инструменты: Hadoop, Spark, Kafka, Hive, Flink.

- Базы данных: NoSQL (MongoDB, Cassandra), SQL (PostgreSQL, MySQL).

- Обработка данных: ETL, Data Pipelines, Data Warehousing.

- Облачные платформы: AWS, Google Cloud, Azure.

- Не стоит указывать навыки, не связанные с Big Data, например, дизайн или маркетинг.

Как описать опыт работы в резюме, если проекты были сложными и нестандартными?

Для описания сложных проектов используйте структуру STAR (Situation, Task, Action, Result):

Ситуация: Разработка системы обработки данных для компании с объемом данных 1 ТБ/день.

Задача: Оптимизация обработки данных для снижения времени выполнения задач на 30%.

Действия: Реализация ETL-процессов с использованием Apache Spark и оптимизация запросов в Hive.

Результат: Время обработки данных сокращено на 35%, затраты на инфраструктуру снижены на 20%.

Просто перечислить технологии без контекста: "Использовал Spark и Hive."

Что делать, если у меня нет опыта работы с Big Data, но я хочу попасть в профессию?

Если у вас нет опыта, акцентируйте внимание на:

- Образовании: Укажите курсы, сертификаты или проекты, связанные с Big Data.

- Пет-проекты: Опишите проекты, которые вы реализовали самостоятельно, например, анализ данных с использованием Python и Pandas.

- Навыки: Подчеркните знание SQL, Python и основ распределенных систем.

- Не стоит писать, что у вас "нет опыта". Лучше сфокусироваться на том, что вы готовы учиться и уже начали применять знания.

Пример: "Разработал пет-проект по анализу данных из социальных сетей с использованием Apache Spark и Python. Реализовал ETL-процесс для обработки 10 ГБ данных."

Как указать достижения, если я работал в команде?

Даже в командных проектах важно выделить ваш личный вклад:

- Уточняйте роль: "В качестве разработчика отвечал за реализацию модуля обработки данных."

- Используйте цифры: "Участвовал в проекте, который позволил сократить время обработки данных на 25%."

- Не стоит писать: "Мы сделали проект." Лучше уточнить, что именно вы сделали.

Пример: "Разработал и внедрил модуль для обработки потоковых данных с использованием Apache Kafka, что позволило сократить задержку обработки на 20%."

Какие ошибки чаще всего допускают в резюме Big Data Developer?

Самые распространенные ошибки:

- Перечисление технологий без контекста: "Использовал Hadoop и Spark."

- Отсутствие конкретики: "Работал с большими данными."

- Ошибки в грамматике и оформлении.

- Рекомендация: Указывайте конкретные примеры, результаты и метрики.

"Работал с Hadoop."

"Разработал и оптимизировал ETL-процессы с использованием Hadoop, что сократило время обработки данных на 30%."

Как указать сертификаты и курсы в резюме?

Сертификаты и курсы должны быть актуальными и релевантными:

- Пример: "Сертификат AWS Certified Big Data – Specialty (2025 год)."

- Пример: "Курс 'Advanced Big Data with Spark and Hadoop' от Coursera (2025 год)."

- Не стоит указывать сертификаты, не связанные с Big Data, например, "Курс по графическому дизайну."

Как написать цель в резюме для Big Data Developer?

Цель должна быть конкретной и отражать ваши амбиции:

Пример: "Ищу позицию Big Data Developer, где смогу применить свои навыки в разработке и оптимизации систем обработки данных для улучшения бизнес-процессов."

"Хочу работать в компании."

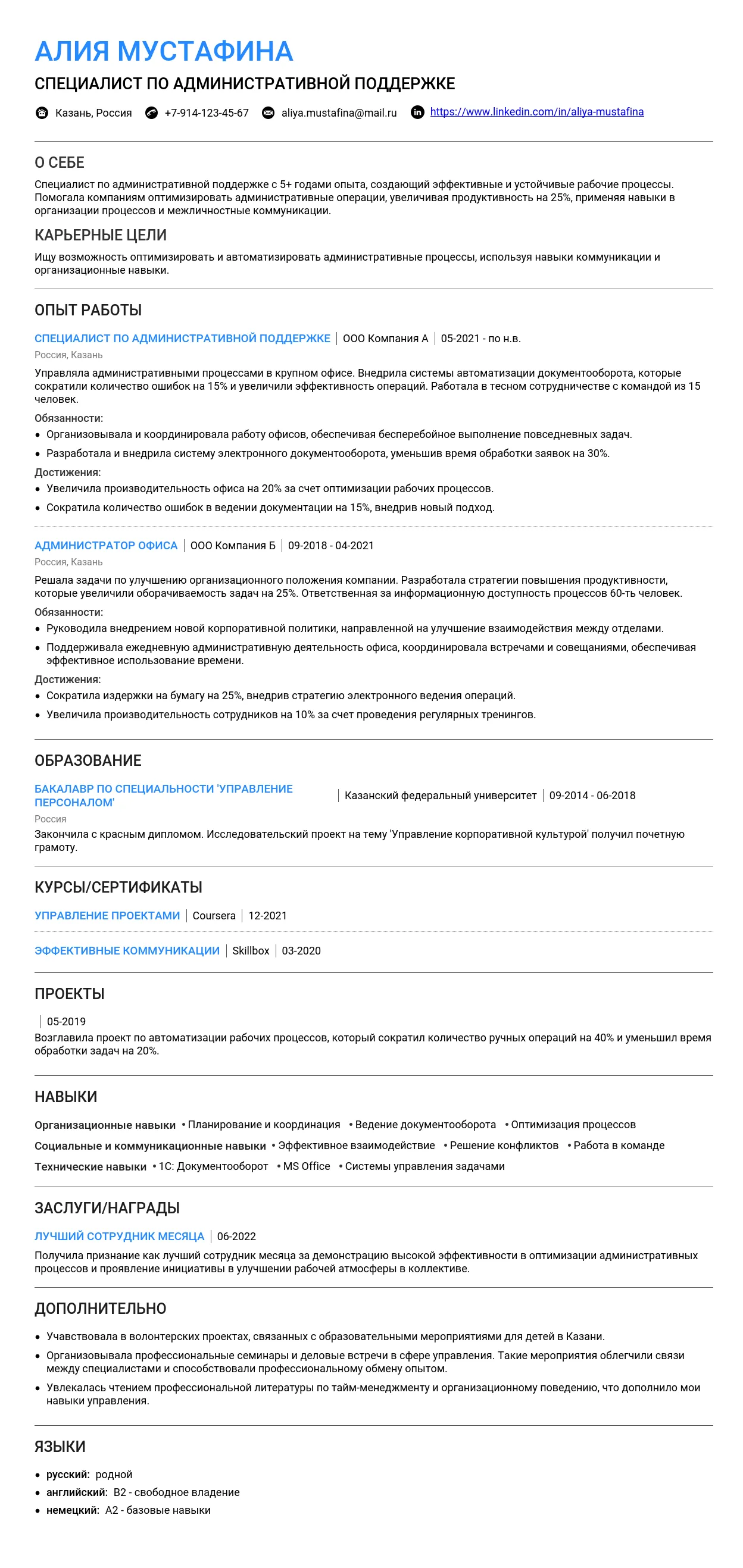

Пример резюме Администратора 2025 - Как составить

Пример резюме Администратора 2025 - Как составить

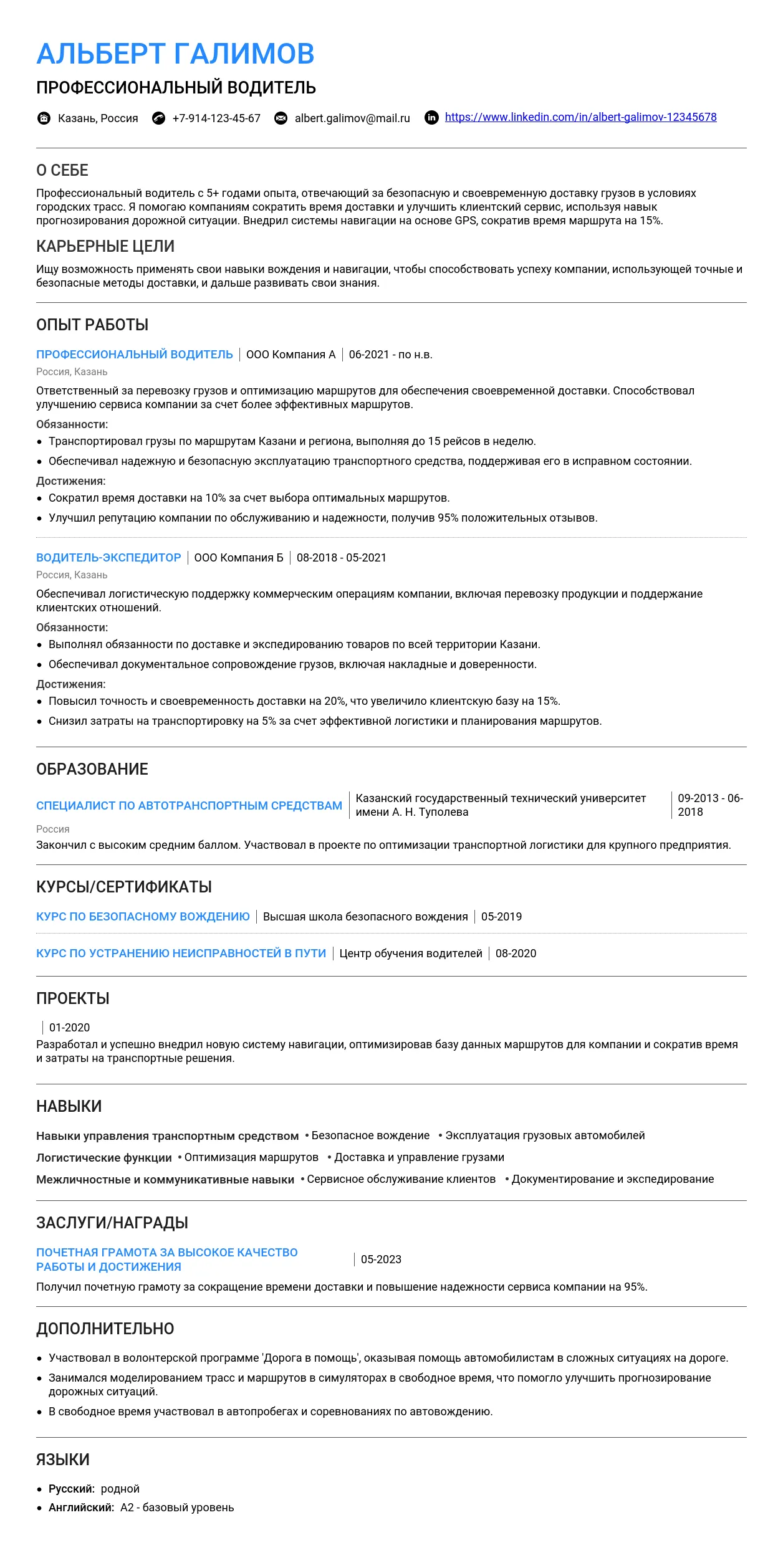

Пример резюме Водителя 2025 - готовый вариант

Пример резюме Водителя 2025 - готовый вариант

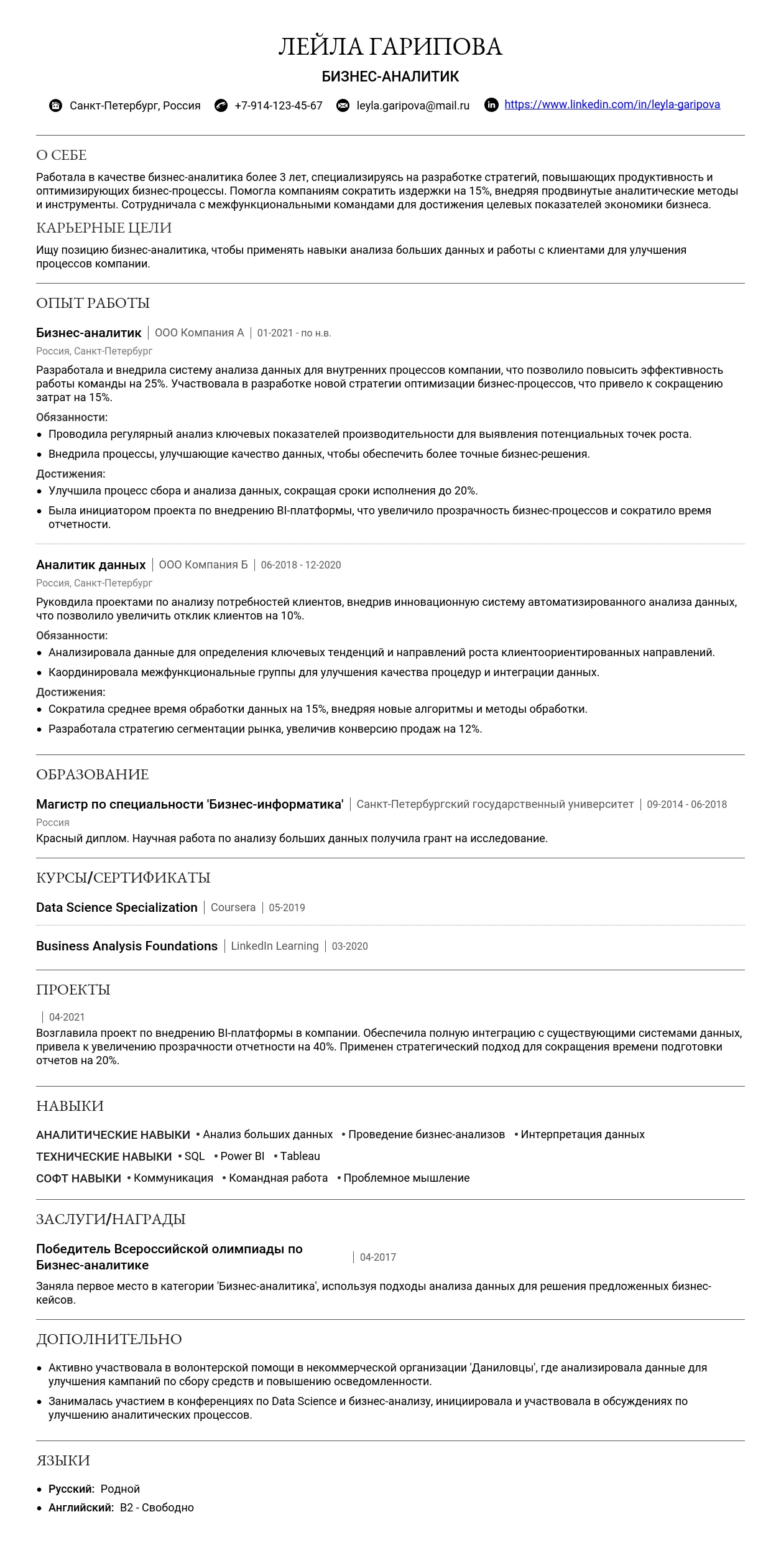

Пример резюме Аналитика 2025 - готовые примеры

Пример резюме Аналитика 2025 - готовые примеры

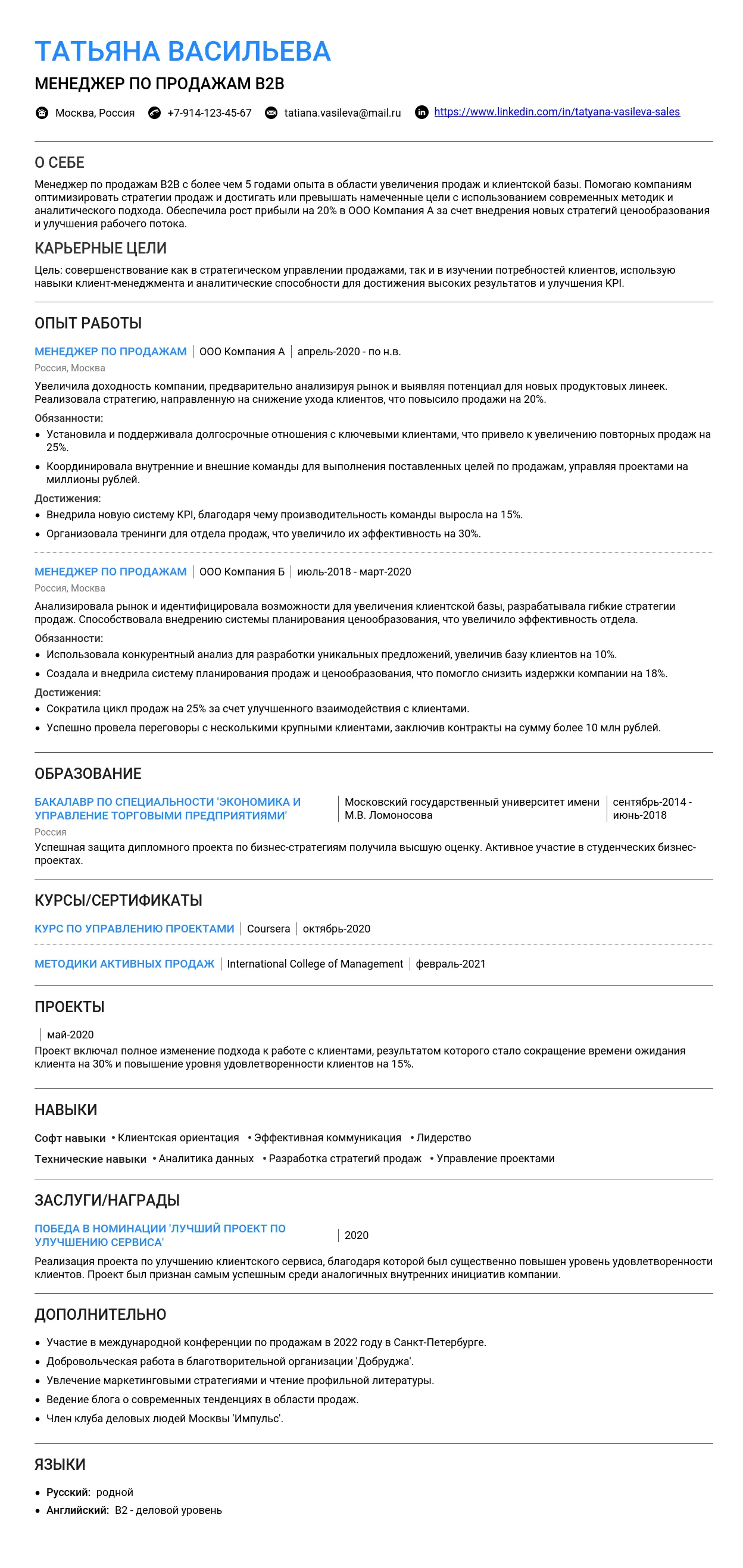

Пример резюме Менеджера по продажам 2025 - Как составить

Пример резюме Менеджера по продажам 2025 - Как составить

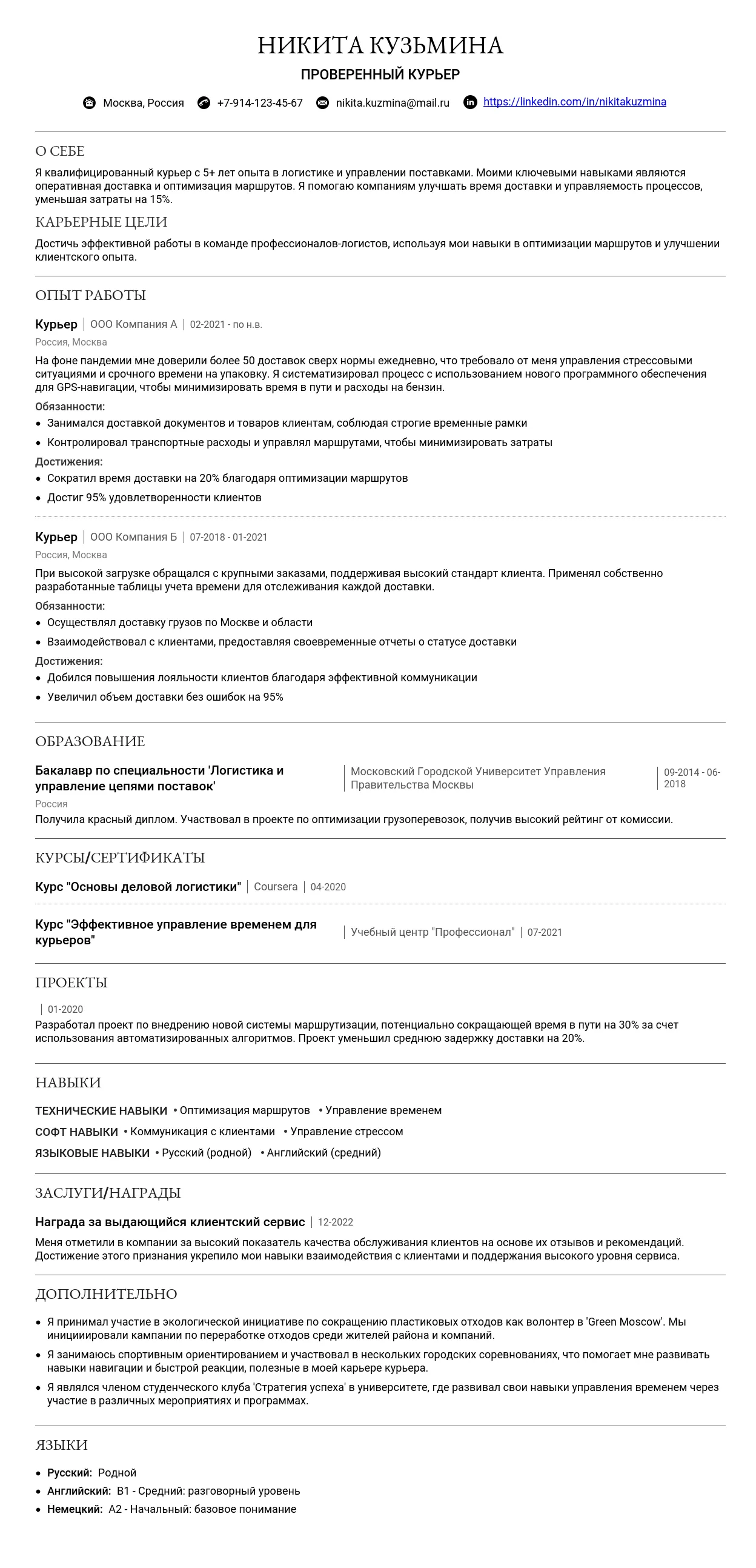

Пример резюме Курьера 2025 - Как составить

Пример резюме Курьера 2025 - Как составить

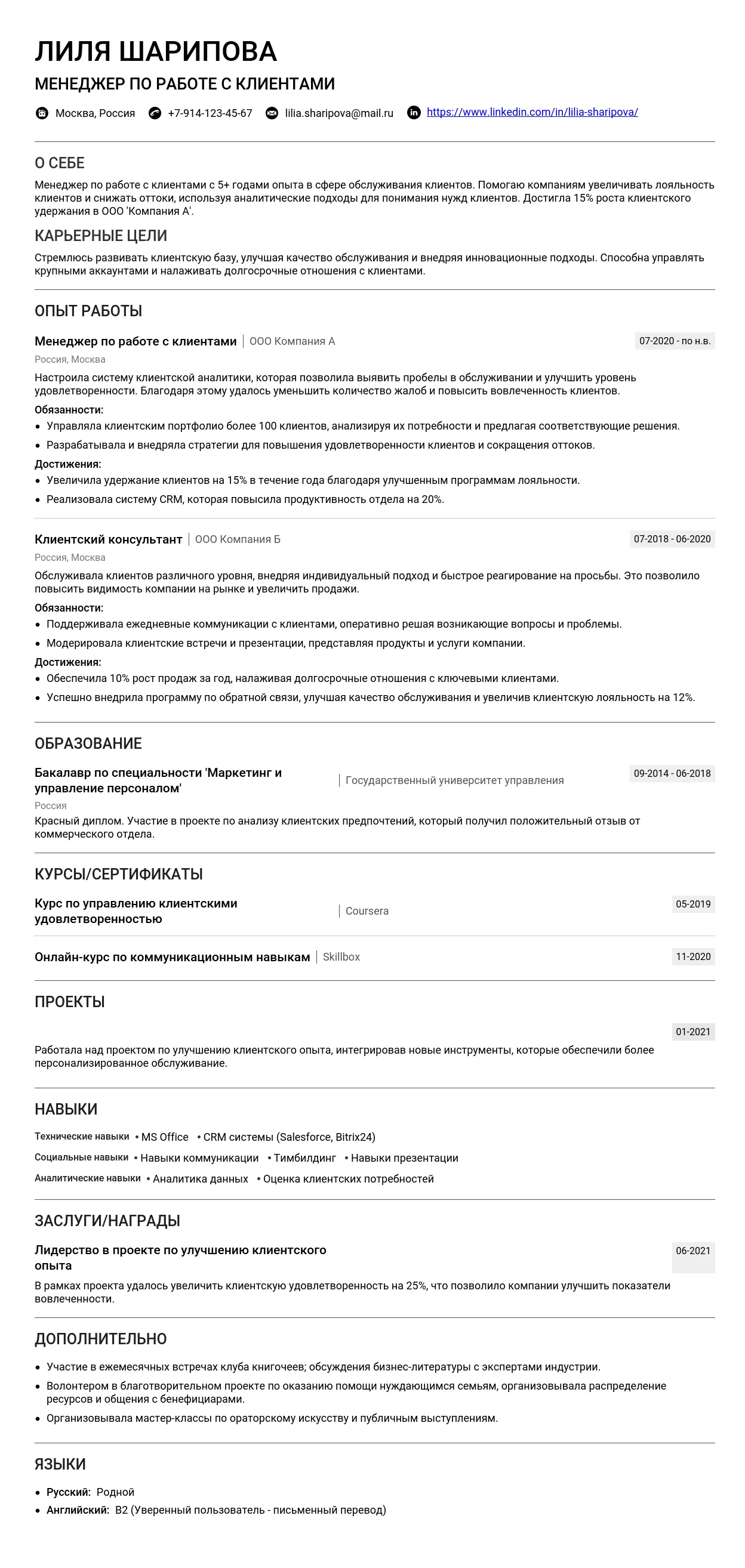

Пример резюме менеджера по работе с клиентами 2025 - Готовые примеры

Пример резюме менеджера по работе с клиентами 2025 - Готовые примеры

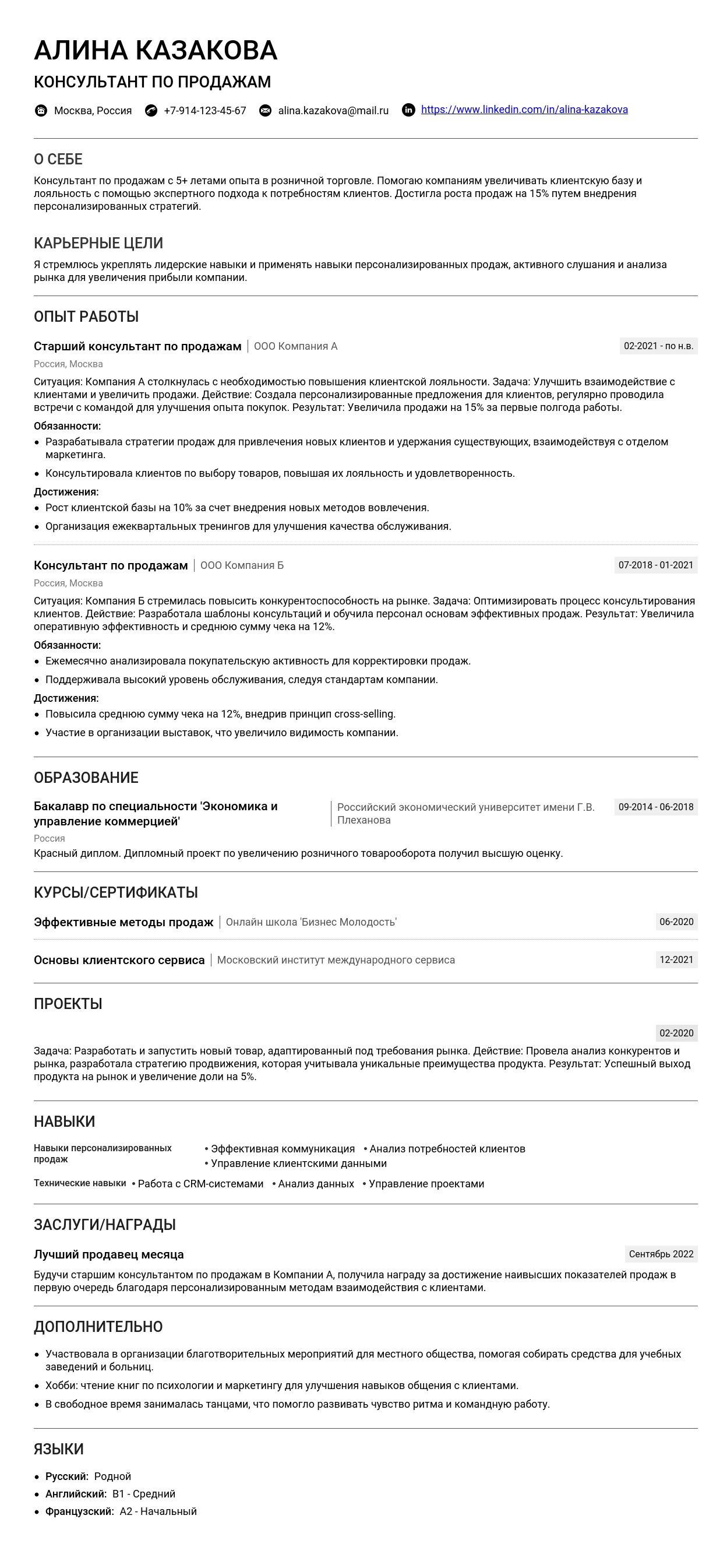

Пример резюме Продавца-консультанта 2025 - советы

Пример резюме Продавца-консультанта 2025 - советы

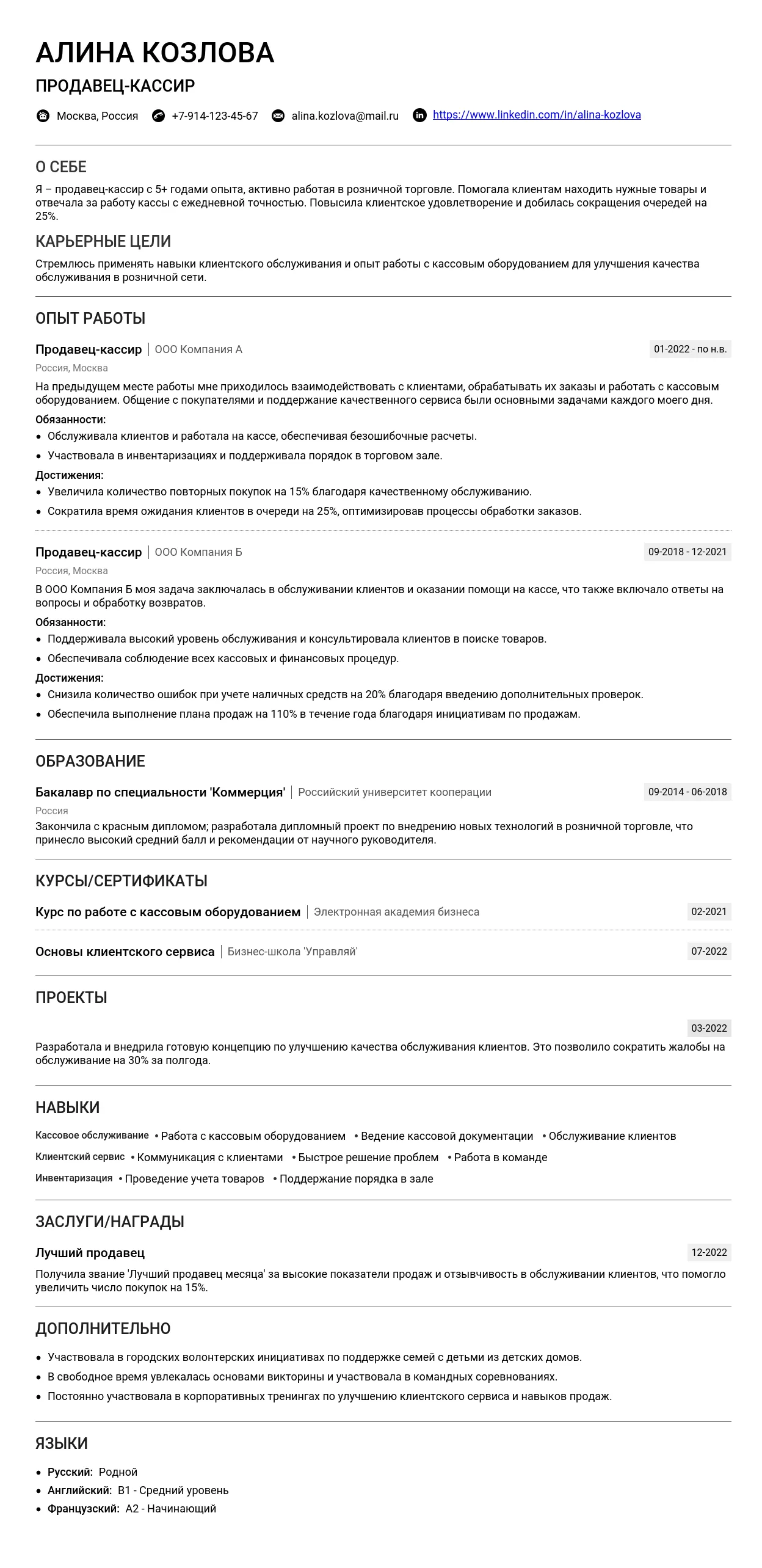

Пример резюме продавца-кассира 2025 - Как составить

Пример резюме продавца-кассира 2025 - Как составить

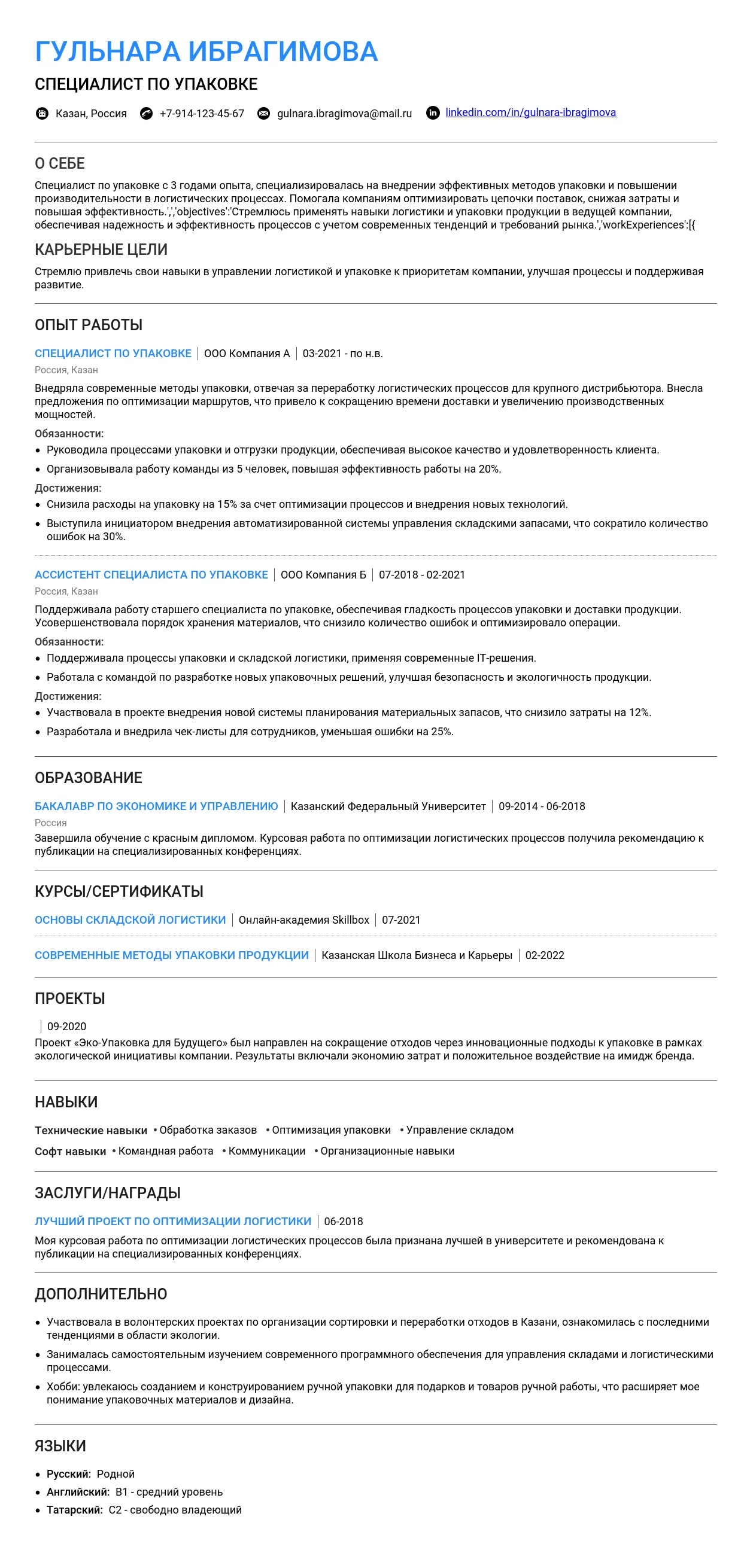

Пример резюме Упаковщика 2025 - как составить

Пример резюме Упаковщика 2025 - как составить